Привет, сегодня мы расскажем о том, как создать правильный robots.txt и зачем он вообще нужен.

Содержание:- Что такое robots txt

- Как создать правильный robots txt

- Директива User-agent

- Директивы Allow и Disallow

- Спецсимволы * и $

- Директива sitemap

- Директива Host

- Кириллица в robot txt

- Настройка robots txt в MogutaCMS

Что такое robots txt

В одной из наших прошлых статей мы рассказывали и том, как работают поисковые роботы. Файл robots txt даёт инструкции поисковым роботам, о том, как правильно индексировать ваш сайт. С помощью директив вы можете, например, указать роботу какие страницы или директории следует индексировать, а какие нет, сформировать группу зеркал для вашего сайта(если они у вас есть), указать путь к файлу sitemap и так далее. В основном его используют именно для запрета индексации определённых страниц сайта.

Как создать правильный robots txt

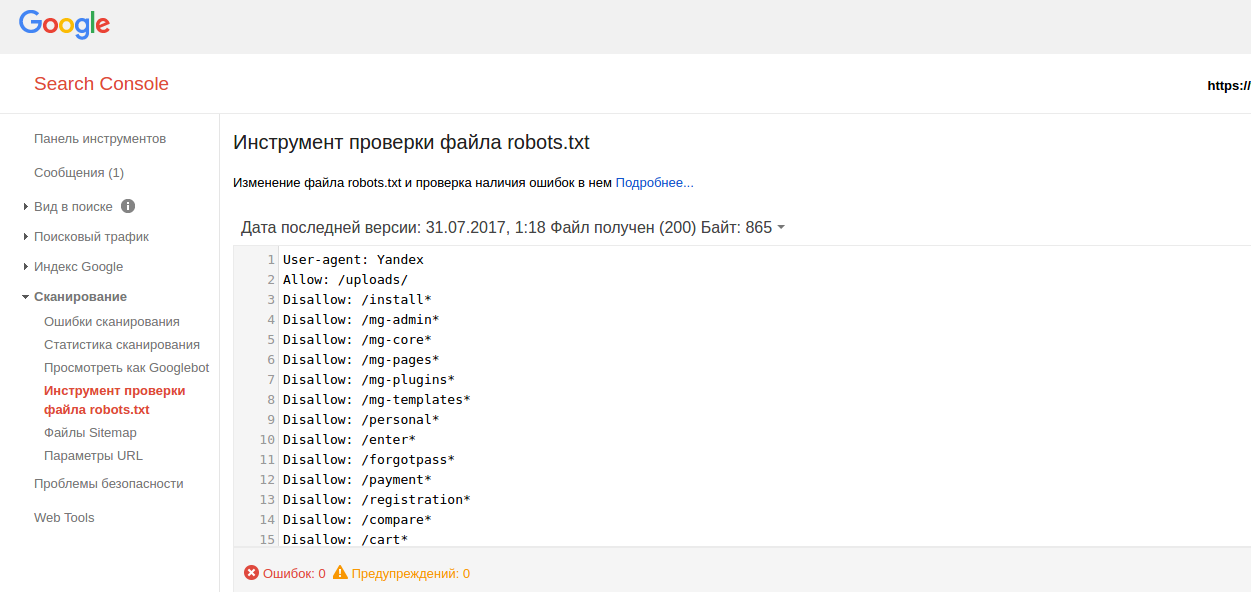

В любом текстовом редакторе создайте файл с именем robots txt. Затем, используя директивы описанные ниже, укажите роботу на страницы сайта, которые надо добавить или же наоборот убрать из поисковой выдачи. После того, как вы создали файл, проверьте его на наличие ошибок с помощью Яндекс вебмастера или Google Search Console.

Готовый файл поместите в корневой каталог вашего сайта(там, где находится файл index.html).

Директива User-agent

Это своеобразное приветствие поисковых роботов.

Строка "User-agent:*" Скажет, что все поисковые роботы могут использовать инструкции, содержащиеся в этом файле. А, например, строка "User-agent: Yandex" даст инструкции только для поискового робота яндекса. Примеры использования указаны ниже. Также у поисковых систем есть вспомогательные роботы для разных категорий. Например, YandexNews и Googlebot-News - это роботы для работы с новостями.

Директивы Allow и Disallow

С помощью директивы Disallow вы указываете какие страницы или каталоги сайта запрещено индексировать. А с помощью директивы Allow, соответственно, можно.

Примеры:User-agent:*

Disallow: /

Allow: /catalog/

Такая запись сообщит всем поисковым роботам, что из всего сайта им можно индексировать только директорию catalog.

Кстати, символ # предназначен для описания комментариев. Все, что находится после этого символа и до конца строки не учитывается.

А вот пример robots txt с указанием индивидуальных инструкций для разных поисковиков:

#разрешает роботу индексировать весь сайт, кроме раздела с велосипедами

User-agent:*

Disallow: /велосипеды/

#запрещает роботу индексировать сайт, кроме раздела с лодками

User-agent: Googlebot

Allow: /лодки/

Disallow:/

#запретит всем остальным поисковым системам индексировать сайт

User-agent: *

Disallow: /

Обратите внимание, что между директивами User-agent, Allow и Disallow не может быть пустых строк!

Спецсимволы * и $

В директивах allow и Disallow можно использовать спецсимволы * и $, чтобы задавать регулярные выражения. *-выбирает указанную последовательность

Например:#Запрещает роботам индексировать все страницы, url которых содержит private

User-agent:*

Disallow: /*private

По умолчанию в конце каждого правила необходимо прописать спецсимвол *. А чтобы отменить * в конце правила используется символ $.

Например:# запрещает '/lock'

# но не запрещает '/lock.html'

User-agent:*

Disallow: /lock$

Комментарии (0)